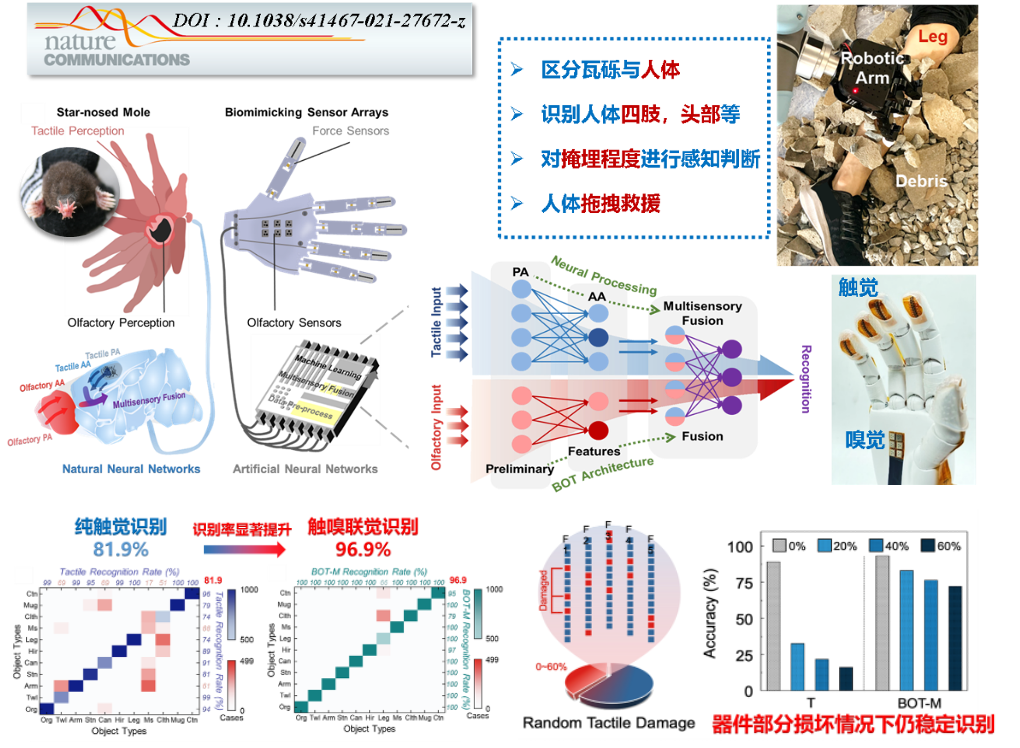

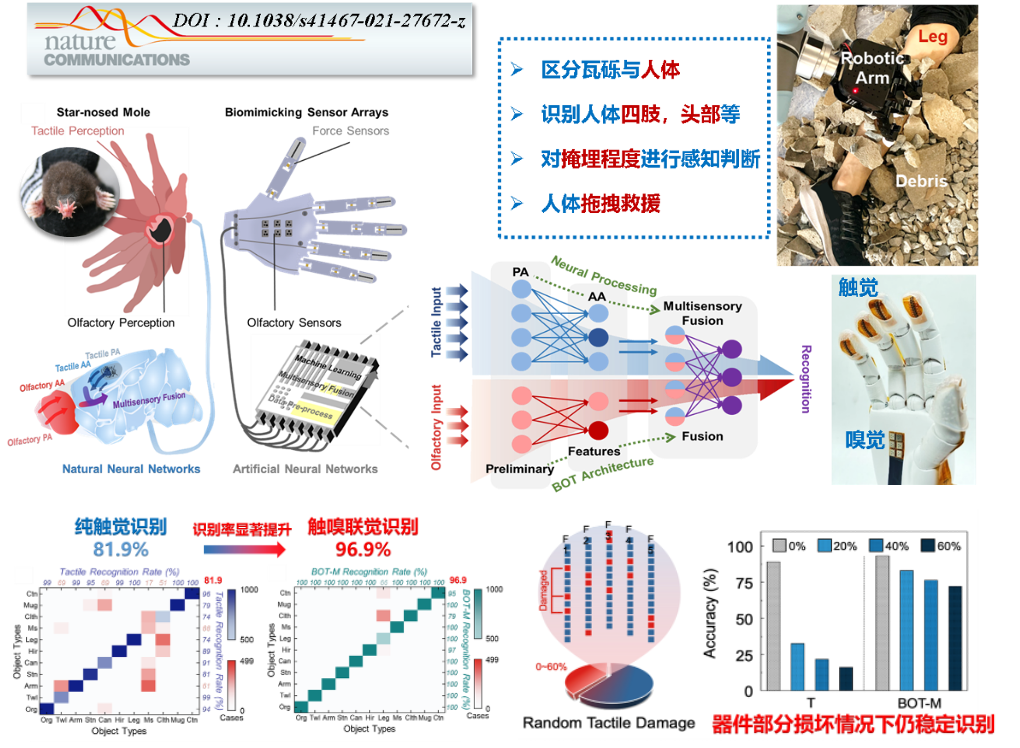

研制出触嗅一体智能仿生机械手,实现应急救援掩埋场景下人体识别救援

文章来源:一室 | 发布时间:2022-01-11

文章来源:一室 | 发布时间:2022-01-11 | 【打印】 【关闭】

由地震、滑坡、塌方等掩埋事故造成的视觉感知障碍对受困人员的搜索和定位造成了极大阻碍。为了确保最佳救援时机,提升搜救成功率和生还率,依托国家科技创新2030“新一代人工智能”重大项目,针对极端环境无视觉输入情况下对受困人员的识别与救援需求,中国科学院上海微系统与信息技术研究所陶虎团队受自然界星鼻鼹鼠“触嗅融合”感知启发,将MEMS嗅觉、触觉柔性传感器阵列与多模态机器学习算法融合,构建了仿星鼻鼹鼠触嗅一体智能机械手(图1)。得益于硅基MEMS气体传感器(灵敏度超越人类1个数量级)、压力传感器(探测限超越人类1个数量级)的优异性能,该机械手手指触摸物体后可准确获取其局部微形貌、材质硬度和整体轮廓等关键特征,掌心可同步嗅出物体“指纹”气味,进一步通过仿生触嗅联觉 (BOT) 机器学习神经网络实时处理,最终完成识别人体、确认部位、判断掩埋状态、移开障碍物、闭环救援。

与应急管理部上海消防研究所合作,通过到一线消防救援单位实地调研,真实还原构建了人体被瓦砾石堆覆盖的掩埋场景,在此环境下对包括人体在内的11种典型物体进行识别,触嗅联觉识别准确率达96.9%,较单一感觉提升了15%。相较麻省理工学院发表于Nature(DOI:10.1038/s41586-019-1234-z)的单一触觉(548个传感器)感知研究,本工作通过触(70个)、嗅(6个)联觉,仅使用1/7数量的传感器,达到了更理想的识别目的。并且缩小后的传感器规模和样本量,更适合复杂环境、资源有限条件下的快速反应和应用。除此之外,面对在实际救援中经常遇见的存在干扰气体或器件部分损坏等情况,通过多模态感知的互补和神经网络的快速调节,该系统仍保持良好的准确率(>80%)。

相关研究成果以“A star-nose-like tactile-olfactory bionic sensing array for robust object recognition in non-visual environments”为题于2022年1月10日发表在国际重要学术期刊Nature Communications(Nat. Commun. 2022, 13, 79.)上。

该论文的通讯作者为上海微系统所陶虎研究员、第一通讯单位为中科院上海微系统所,合作单位有应急管理部上海消防研究所、中科院自动化所、苏州慧闻纳米科技有限公司。该工作得到科技创新2030-重大项目、国家重点研发计划、国家自然科学基金优秀青年基金、中国科学院基础前沿科学研究计划“从0到1”原始创新项目、上海市优秀学术带头人计划等相关研究计划的支持。

图1. 用于应急救援掩埋场景的触嗅一体仿生智能机械手